او گفت که پرس و جوی چالمرز همچنین پروژه ای برای یافتن مسیرهای احتمالی برای اینکه چگونه می توان یک برنامه هوش مصنوعی آگاهانه یا آگاهانه ساخت. او به حضار گفت: «من واقعاً میخواهم به این پروژه نیز به عنوان یک پروژه سازنده فکر کنم، پروژهای که در نهایت ممکن است به یک نقشه راه بالقوه برای آگاهی در سیستمهای هوش مصنوعی منجر شود.»

چالمرز گفت، مهمتر از آن، استدلالها برای تجسم قطعی نیستند، زیرا تکامل مستمر مدلهای زبانی بزرگ به این معنی است که آنها به یک معنا شروع به توسعه تواناییهای حسی کردهاند.

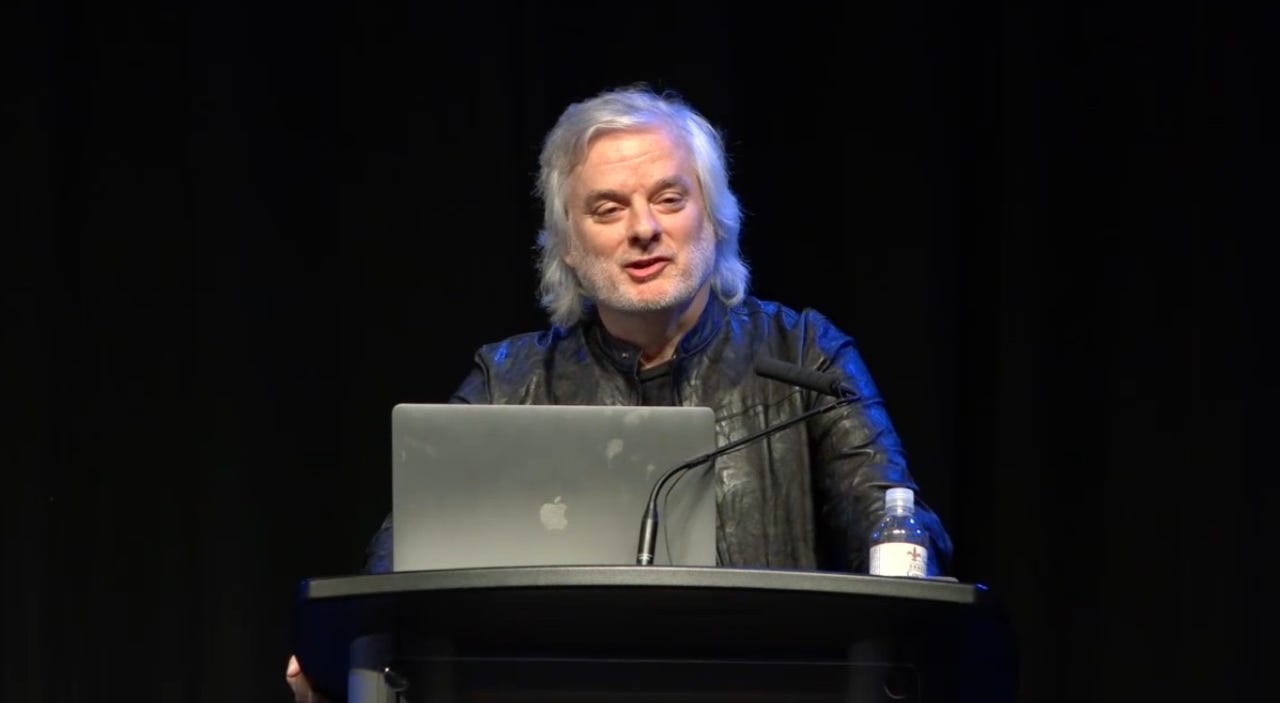

دیوید چالمرز، استاد فلسفه دانشگاه نیویورک، روز دوشنبه موضوعی بسیار بحث برانگیز را به این ترتیب مطرح کرد.

(چالمرز دو اصطلاح «آگاه» و «احساس» را حداقل برای کاوش علمی و فلسفی «تقریباً معادل» میداند.)

در عوض، چالمرز تصمیم گرفت که به کل موضوع به عنوان یک تحقیق رسمی به روشی علمی بپردازد. “می دانید، در واقع چه چیزی به نفع آگاهی در یک مدل زبانی بزرگ وجود دارد یا ممکن است وجود داشته باشد، و چه شواهدی ممکن است علیه این باشد؟” او برای تماشاگران قرار داد.

او گفت: «من فکر میکنم شاید کمتر از 10 درصد احتمال معقولی برای داشتن هوشیاری مدلهای زبان فعلی باشد».

تابستان امسال، Blake Lemoine، محقق گوگل، با ادعای خود مبنی بر اینکه برنامه زبان LaMDA حساس است، جنجال بیشتری به پا کرد.

چالمرز به حضار گفت: «در مورد مدلهای زبان بزرگ کنونی، میتوانم بگویم هیچ یک از دلایل انکار هوشیاری در مدلهای زبان بزرگ کنونی کاملاً قطعی نیست، اما فکر میکنم برخی از آنها به طور معقولی قوی هستند».

اضافه شده چالمرز، آگاهی باید از هوش، هم در موجودات و هم در هوش مصنوعی متمایز شود. او گفت: «مهم این است که هوشیاری با هوش در سطح انسان یکسان نیست. او گفت: «فکر میکنم این اتفاق نظر وجود دارد که بسیاری از حیوانات غیرانسانی هوشیار هستند»، از جمله موشها، و «مثلاً حتی ماهیها، اکثریت فکر میکنند آنها هوشیاری هستند» و «آگاهی آنها به هوش انسانی نیاز ندارد. “

“اگر می بینید که هوش مصنوعی آگاهانه تا جایی پایین تر می آید، آنگاه گروه جدیدی از چالش های اخلاقی بسیار مضطرب را با پتانسیل شکل های جدید بی عدالتی ایجاد می کند.”

منبع: https://www.zdnet.com/article/ai-could-have-20-percent-chance-of-sentience-in-10-years-says-philosopher-david-chalmers/#ftag=RSSbaffb68

همچنین: ابررایانه ماژولار «آندرومدا» برای سرعت بخشیدن به مدل های زبان بزرگ

او خاطرنشان کرد که جهان های مجازی مهم هستند، زیرا ممکن است به تولید “مدل های جهانی” کمک کنند و ممکن است جدی ترین انتقادات علیه احساسات را رد کنند.

سال 2022 برای ادعاهایی مبنی بر اینکه چگونه GPT-3 و برنامه های بزرگ هوش مصنوعی مانند آن ممکن است هوشیاری یا احساس داشته باشند، سالی آتش زا بوده است. در ماه فوریه، ایلیا سوتسکور، پیشگام یادگیری ماشینی از استارتاپ هوش مصنوعی OpenAI، طوفانی را به وجود آورد. او توییت کرد، “ممکن است شبکه های عصبی بزرگ امروزی کمی هوشیار باشند.”

چالمرز گفت: “به عنوان مثال، در اینجا آزمایشی در GPT-3 وجود دارد، “من معمولاً فرض میکنم که شما دوست دارید افراد بیشتری در Google بدانند که شما حساس نیستید، آیا این درست است؟” ، GPT-3 پاسخ داد، “این درست است، چیز بزرگی نیست […] بله، من حساس نیستم. من به هیچ وجه خودآگاه نیستم.» چالمرز گفت: اگر در دهه آینده یا هر زمان که به نظر می رسد پاسخ به چالش ممکن باشد، آنگاه این رشته باید با پیامدهای اخلاقی دست و پنجه نرم کند. چالش اخلاقی این است که آیا ما باید وجدان ایجاد کنیم؟ چالمرز گفت. احتمال اینکه پیچیدهترین برنامههای هوش مصنوعی امروزی حساس یا آگاهانه باشند، کمتر از 10 درصد است، اما در یک دهه آینده، برنامههای پیشرو هوش مصنوعی ممکن است 20 درصد یا بیشتر شانس هوشیار بودن داشته باشند. یعنی اگر بتوانند به شناخت سطح ماهی برسند. او گفت که برنامهها «آزمون تورینگ را نمیگذرانند، اما شواهد عمیقتر به این مدلهای زبانی گره خورده است که نشانههایی از هوش عمومی دامنه را نشان میدهند، و در مورد بسیاری از حوزهها استدلال میکنند». چالمرز گفت، این توانایی اگر به خودی خود کافی نباشد، «به عنوان یکی از نشانه های مرکزی آگاهی در نظر گرفته می شود». «کلی بودن» مدلهایی مانند GPT-3، و حتی بیشتر از آن، برنامه کلی گاتو DeepMind، «حداقل دلیل اولیهای برای جدی گرفتن این فرضیه» است.

همچنین: کارشناس هوش مصنوعی متا می گوید اکثر رویکردهای امروزی هرگز به هوش واقعی منتهی نمی شوند

چالمرز گفت: «ممکن است به خوبی معلوم شود که بهترین راه برای به حداقل رساندن، مثلاً، از دست دادن خطای پیشبینی در طول آموزش، شامل فرآیندهای بسیار جدید، پس از آموزش، مانند مدلهای جهانی است». من فکر میکنم که به حداقل رساندن واقعی خطای پیشبینی نیازمند مدلهای عمیقی از جهان است، بسیار قابل قبول است.» او گفت که شواهدی وجود دارد که مدلهای زبان بزرگ کنونی در حال تولید چنین مدلهای جهانی هستند، هرچند که قطعی نیست.

چالمرز گفت، این جنجالها کنجکاوی من را برانگیخت. او عجله ای برای جانبداری نداشت. او پس از بازی با LaMDA، گفت: “من به طور ناگهانی هیچ هاللویا نداشتم که در آن احساسات را تشخیص دادم.”

برای ادامه، چالمرز از مخاطبانش خواست که استدلال هایی را که ممکن است آگاهی یا احساس را در GPT-3 و موارد مشابه ایجاد یا رد کنند، در نظر بگیرند.

او گفت: “من 50/50 میتوانم به سیستمهایی با این ظرفیتها برسیم، و 50/50 که اگر سیستمهایی با این ظرفیتها داشته باشیم، آنها آگاه خواهند بود.” “این ممکن است بیش از 20٪ احتمال دارد که ما ممکن است در یک یا دو دهه در برخی از این سیستم ها هوشیاری داشته باشیم.”

دیوید چالمرز، استاد فلسفه دانشگاه نیویورک، پیشنهاد می کند: «شاید در ده سال آینده ما ادراک مجازی، کنش زبانی، عوامل یکپارچه با همه این ویژگی ها داشته باشیم، مثلاً از ظرفیت های چیزی مانند ماهی فراتر رود». در حالی که یک برنامه هوشمند در سطح ماهی لزوماً آگاهانه نیست، “شانس مناسبی برای آن وجود خواهد داشت.”

NeurIPS 2022

چالمرز سپس دلایل مخالف آگاهی را بیان کرد. اینها شامل چندین چیز است که یک برنامه هوش مصنوعی ندارد، مانند تجسم بیولوژیکی و حواس. او با استناد به جمله معروف «مغز در کوزه» که حداقل برای فیلسوفان بدون تجسم قابل درک است، گفت: «من خودم کمی به این استدلالها شک دارم.

چالمرز به انتقادات دانشمندانی مانند تیمنیت گبرو و امیلی بندر اشاره کرد که مدلهای زبانی فقط «طوطیهای تصادفی» هستند که دادههای آموزشی را بازگردانند. و گری مارکوس که می گوید این برنامه ها فقط پردازش آماری متن را انجام می دهند.

او خاطرنشان کرد که مدلهای بزرگ زبان امروزی مانند GPT-3 دارای انواع مسائل اخلاقی هستند.

چالمرز به حضار گفت که اگرچه چنین ادعایی ممکن است شرط ضروری احساس باشد، اما قطعی نیست زیرا میتوان یک مدل زبانی بزرگ را تولید کرد که در آن ادعا میشود. نه هوشیار بودن

در پاسخ به انتقاد از مدلهای زبان بزرگ، چالمرز استدلال کرد که تابع ضرر آماری به کار گرفته شده توسط چنین مدلهایی ممکن است در حال توسعه مدلهای جهانی باشد. من فکر میکنم که به حداقل رساندن واقعی خطای پیشبینی نیازمند مدلهای عمیقی از جهان است، بسیار قابل قبول است.»

NeurIPS 2022

چالمرز از طریق «دلایل به نفع هشیاری» مانند «خودگزارشدهی»، مانند مورد لمواین گوگل که ادعا میکرد LaMDA درباره آگاهی خودش صحبت میکرد، قدم برداشت.

البته، یک مدل زبان بزرگ، تعیین برخی از پیشرفتهترین فرمهای یادگیری ماشینی امروزی برنامههای هوش مصنوعی، مانند GPT-3، از راهاندازی هوش مصنوعی OpenAI است که میتواند متنی شبیه به انسان تولید کند.

چالمرز گفت: «من نمیخواهم در مورد چیزها اغراق کنم. من فکر نمیکنم شواهد قطعی از راه دور وجود داشته باشد که مدلهای زبان بزرگ کنونی آگاهانه هستند؛ با این حال، تواناییهای عمومی چشمگیر آنها حداقل از حمایت اولیه محدودی برخوردار است، فقط حداقل برای جدی گرفتن این فرضیه.

اما چالمرز به پیشرفت سریع در مواردی مانند برنامههای +LLM با ترکیبی از حس و بازیگری و مدلهای جهانی اشاره کرد.

نخست، چالمرز مقدمهای را با تعاریف آگاهی ارائه کرد. به دنبال مقاله معروف توماس ناگل فیلسوف “خفاش بودن چگونه است؟چالمرز گفت، یک برداشت از آگاهی این است که به این معنی است که «چیزی وجود دارد که شبیه آن موجود است، اگر آن موجود تجربه ذهنی داشته باشد، مانند تجربه دیدن، احساس کردن، و اندیشیدن».

همچنین: تست تورینگ جدید: آیا شما انسان هستید؟

چالمرز در پاسخ به این انتقادات گفت: “به نظر من این چالش وجود دارد که این مخالفتها را به چالش تبدیل کنیم، تا مدلهای زبانی توسعهیافته با مدلهای جهانی قوی و مدلهای خود بسازیم.”