با استفاده از این رویکرد، IBM قصد دارد با عمودهای مختلف و موارد مختلف استفاده از هوش مصنوعی مقابله کند. تعداد انگشت شماری دامنه وجود دارد که شرکت در حال ساخت مدل های پایه برای آن ها است – این موارد کاربرد حوزه هایی مانند شیمی و داده های سری زمانی را پوشش می دهند. دادههای سری زمانی، که صرفاً به دادههایی که در فواصل زمانی منظم جمعآوری میشوند، اشاره میکنند، برای شرکتهای صنعتی که نیاز به مشاهده نحوه عملکرد تجهیزات خود دارند، حیاتی است. پس از ساخت مدل های پایه برای تعداد انگشت شماری از مناطق کلیدی، IBM می تواند پیشنهادات خاص تر و عمودی را توسعه دهد. تیم همچنین اطمینان حاصل کرده است که نرم افزار AIU کاملاً با پشته نرم افزار Red Hat متعلق به IBM سازگار است.

قدرت محاسباتی هوش مصنوعی رو به اتمام است. IBM می گوید که پاسخ این تراشه جدید است

منبع: https://www.zdnet.com/article/ai-is-running-out-of-computing-power-ibm-says-the-answer-is-this-new-chip/#ftag=RSSbaffb68

برنز گفت: برای آیبیام، ساخت راهحلهای کامل که بهطور مؤثر جهانی هستند، منطقیتر است، «بهگونهای که بتوانیم آن قابلیتها را در پلتفرمهای محاسباتی مختلف ادغام کنیم و از طیف بسیار بسیار گستردهای از نیازهای هوش مصنوعی سازمانی پشتیبانی کنیم».

همچنین: من یک مولد هنر هوش مصنوعی را آزمایش کردم و این چیزی است که یاد گرفتم

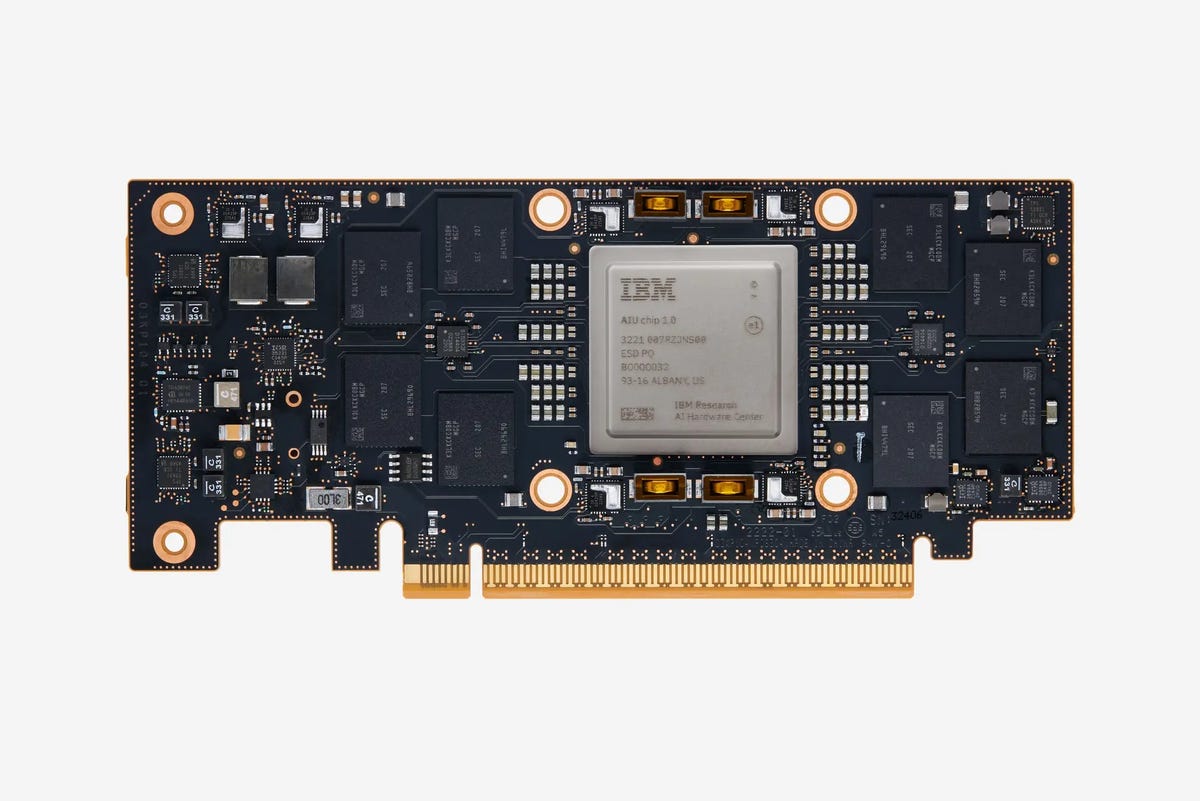

AIU اولین سیستم کامل روی یک تراشه (SoC) از مرکز سخت افزار هوش مصنوعی تحقیقاتی IBM است که به صراحت برای اجرای مدل های یادگیری عمیق هوش مصنوعی سازمانی طراحی شده است.

IBM استدلال میکند که “اسب محاسبات سنتی” که به عنوان CPU شناخته میشود، قبل از رسیدن به یادگیری عمیق طراحی شده است. در حالی که CPU ها برای برنامه های کاربردی همه منظوره خوب هستند، اما در آموزش و اجرای مدل های یادگیری عمیق که به عملیات موازی هوش مصنوعی نیاز دارند، چندان خوب نیستند.

تکنیک محاسباتی تقریبی AIU به آن اجازه می دهد تا از محاسبات ممیز شناور 32 بیتی به فرمت های بیتی که یک چهارم بیشتر اطلاعات را در خود نگه می دارند کاهش یابد.

این هیاهو نشان می دهد که هوش مصنوعی (AI) در حال حاضر در همه جا وجود دارد، اما در واقع فناوری که آن را هدایت می کند هنوز در حال توسعه است. بسیاری از برنامههای هوش مصنوعی با تراشههایی کار میکنند که برای هوش مصنوعی طراحی نشدهاند – در عوض، آنها به CPUهای همه منظوره و GPUهای ساخته شده برای بازیهای ویدیویی متکی هستند. این عدم تطابق منجر به هجوم سرمایهگذاریها – از غولهای فناوری مانند IBM، اینتل و گوگل، و همچنین از استارتآپها و VCها – در طراحی تراشههای جدید که به صراحت برای حجم کاری هوش مصنوعی طراحی شدهاند، شده است.